À un moment où l’industrie, les services, les administrations sont de plus en plus dépendants aux centres de données, il est important que ceux-ci soient durables, mais aussi efficaces et résilients. Pour des datacenters anciens, une rénovation/reconfiguration s’impose souvent pour rapprocher leurs performances de celles de sites neufs bénéficiant des dernières technologies de refroidissement, d’alimentation sécurisée ou de gestion et sécurisation des infrastructures.

La dynamique consistant à rénover les datacenters progresse d’année en année avec des pistes d’améliorations technologiques, mais aussi organisationnelles, pour répondre à de nouvelles contraintes, réglementations, ainsi qu’à l’augmentation de l’activité à distance ou au développement du Edge Computing.

Cette dernière année a montré que nous sommes de plus en plus dépendants de centres de données et que ceux-ci se doivent d’être plus durables, car leur consommation énergétique va être de plus en plus scrutée à la loupe, mais aussi plus résilients et adaptés à l’évolution rapide de leur environnement. Et cela, aussi bien pour le secteur public que pour le secteur privé, car si rien n’est fait, la consommation mondiale des centres de données devrait doubler d’ici à 2040.

Des solutions existent pour répondre à 5 objectifs incontournables :

- optimiser l’efficacité énergétique pour ne pas compromettre notre avenir commun ;

- garantir la continuité de service ;

- assurer la modularité et l’adaptabilité pour accueillir de nouvelles technologies et services ;

- garantir la sécurité des équipements et des données ;

- optimiser les coûts et la gestion des « assets ».

Une première étape d’audit et d’analyse du site, des équipements IT et des installations techniques

Optimiser un datacenter n’est pas toujours une tâche facile, car les charges informatiques et les conditions du milieu extérieur peuvent varier considérablement. Et comme le rappelle Séverine Hanauer, Data Center & Telecom Sales Director-Consulting & Solutions Director de Vertiv France, « le premier paramètre consiste à analyser l’infrastructure du bâtiment existant, son architecture s’il s’agit d’un bâtiment ancien ou plus récent. Les contraintes physiques vont différer, car les matériaux utilisés et l’architecture intérieure impacteront la capacité de réhabilitation et le gain obtenu en efficacité énergétique. Il faut aussi prendre en compte l’environnement du site et la réglementation qui peut limiter la façon dont on peut réaménager le site. Avec, par exemple, des plans locaux d’urbanisme qui limitent le niveau sonore autour du bâtiment ou les différentes réglementations relatives aux gaz réfrigérants. S’il s’agit d’un site en exploitation, les difficultés de mise en œuvre de la rénovation sont variées : comment rénover une partie du site sans tout arrêter, comment conjuguer le planning de toutes les parties prenantes, le phasage de la réhabilitation ou rénovation et, surtout, quelles sont les contraintes côté clients (les services internes de l’entreprise ou les clients utilisateurs d’un datacenter) ? Ce sont autant de choix déterminants pour les choix technologiques envisagés et possibles ».

Une des premières étapes sera aussi d’effectuer un inventaire des équipements IT pour identifier les matériels anciens probablement plus énergivores, donc nécessitant plus de puissance de refroidissement. La mesure du taux réel d’utilisation des serveurs pour détecter ceux qui sont peu utilisés (souvent à moins de 20 %) va aussi permettre d’optimiser les capacités installées, donc de réduire les consommations d’énergie ou d’eau. Autant de surfaces gagnées pour installer de nouveaux matériels. Cette optimisation des centres de données, dans leurs infrastructures informatique et technique est désormais incontournable et doit aussi permettre pour des sites vieillissants d’améliorer la disponibilité et la sécurité tout en réalisant souvent de substantielles économies d’OPEX et d’émissions de gaz à effet de serre.

Première étape : l’analyse et la mesure

Une des premières mesures sera celle du PUE (Power Usage Effectiveness), l’indicateur le plus connu et le plus utilisé, développé par The Green Grid. Il n’est pas toujours mesuré de la même façon, mais reste un bon élément de comparaison, à condition de bien comprendre ce que l’on mesure. Et de le mesurer ! Car 68 % des entreprises interrogées pour le « Baromètre des pratiques Green IT des entreprises en France-2020 » de l’AGIT (Alliance Green IT) ne connaissaient pas la valeur du PUE de leur site. Cette mesure va s’effectuer à partir des consommations des équipements thermiques et électriques du datacenter, mais on verra que dans une deuxième étape, il faudra aussi s’intéresser aux consommations des matériels informatiques.

Depuis plusieurs années, The Green Grid met régulièrement à jour une feuille de route permettant aux opérateurs d’évaluer leur niveau d’efficacité pour toutes leurs opérations, du refroidissement à l’alimentation sécurisée, du calcul au réseau, pour atteindre les meilleures pratiques du numérique. Ce DCMM (Data Center Maturity Model) peut être complété en Europe par le Code of Conduct de l’UE qui englobe tout : l’alimentation, le refroidissement, la conception informatique, la surveillance, la mesure et le contrôle.

UN PACTE POUR DES DATACENTERS CLIMATIQUEMENT NEUTRES

Pour répondre aux engagements de l’European Green Deal de la Commission européenne pour atteindre la neutralité carbone en 2050, 20 associations professionnelles européennes, dont France Datacenter, et 33 opérateurs ont signé le « Climate Neutral Data Center Pact » visant à atteindre un objectif de centres de données « climatiquement neutres » d’ici à 2030. Cet engagement fixe des objectifs ambitieux pour 6 axes :

- efficacité énergétique avec des objectifs de PUE de 1,3 dans les pays froids et 1,4 dans les climats plus chauds ;

- énergie propre avec l’utilisation d’énergies renouvelables ;

- utilisation d’eau mesurée par le WUE et réduite ;

- économie circulaire ;

- énergie circulaire avec la récupération de la chaleur fatale ;

- gouvernance en coopération avec la Commission européenne.

www.climateneutraldatacenter.net

Optimiser le refroidissement du datacenter

Les coûts de refroidissement-climatisation d’un datacenter représentent bien souvent plus de 50 % de la dépense d’énergie du site et doivent donc faire l’objet de toutes les attentions lors de l’étude et des investigations pour rendre son centre de données moins énergivore. De nombreuses solutions peuvent être mises en œuvre pour diminuer les consommations énergétiques de tous les équipements, et des gains devraient suivre. Et, explique Séverine Hanauer, « les gains dépendront de là où on part et de là où on veut aller. Par exemple, si un site a un PUE proche de 3,5 et que l’on veut atteindre un PUE de 1,3, il est clair que trouver et mettre en place une ou des solutions technologiques sera plus difficile si le ratio est un peu plus bas au départ. Les entreprises cherchent aujourd’hui à rationaliser les installations et à proposer aux clients des solutions plus simples à mettre en œuvre et à exploiter. Des solutions qui peuvent être plus facilement standardisées et dupliquées sur différents sites. Les efforts actuels d’urbanisation optimisée des salles permettent d’augmenter le taux d’occupation et notamment le remplissage des baies. Et pour avoir une vision globale de l’optimisation d’un ou de plusieurs sites, l’usage d’un outil DCIM permet de modéliser différentes solutions, en prenant en compte tous les éléments qui composent un datacenter ».

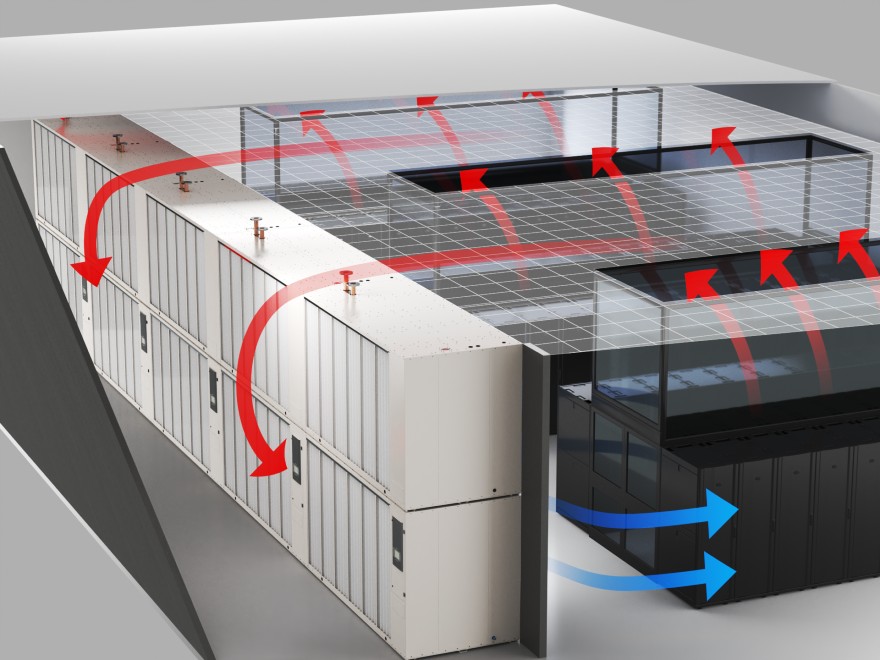

La solution de confinement thermique des baies serveurs et réseaux dans une salle informatique permet, en séparant les flux d’air chaud et d’air froid, d’augmenter de plusieurs degrés la température de refroidissement de la salle, de supprimer les zones de surchauffe, d’avoir une température de retour plus élevée vers l’unité de refroidissement. Une solution qui est encore loin d’être adoptée dans tous les datacenters, en particulier ceux de petites et moyennes surfaces.

Anne Le Crenn Denechère, responsable Marketing et Communication d’Efirack, donne l’exemple d’un opérateur français de télécommunications : « Après analyse comparative entre des systèmes de climatisation inter-baies et climatisation d’ambiance, nous avons conseillé un confinement avec climatisation inter-baies qui répondait à ses 3 objectifs prioritaires : fiabiliser le refroidissement, homogénéiser et monter en densité. Une installation spécifique aux besoins du client de 12 CTU (Confinement Thermique Universel), 400 PDU IP pilotables à distance, 41 climatisations inter-baies à eau glacée Rittal à très haute densité (55 kW de froid pour 0,4 m2) pour 200 baies a été réalisée. Nous avons également conseillé le client sur l’aménagement du plancher technique : passage réseau, eau glacée, courant fort. »

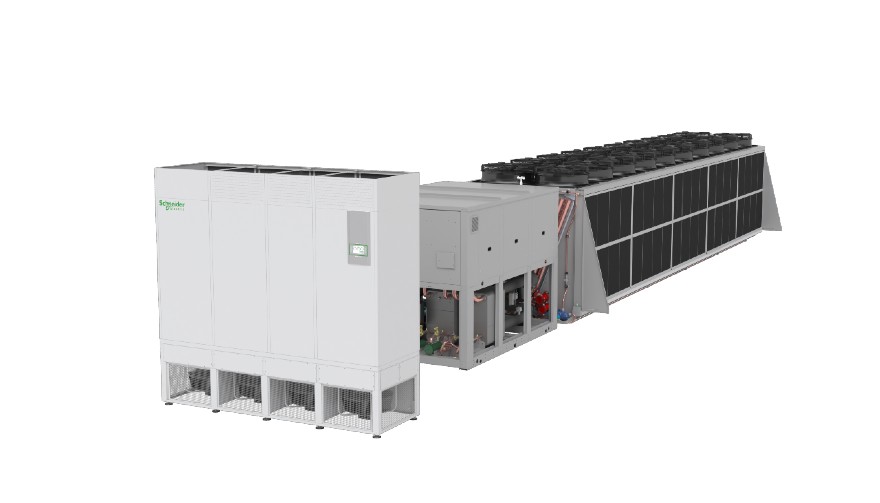

Pour les groupes « froid » pour lesquels les technologies ont beaucoup évolué, avec en particulier l’arrivée du free cooling, les rénovations peuvent être plus complexes. Comme l’explique Damien Giroud, National Sales Director Secure Power France de Schneider Electric, « les solutions de remplacement sont moins standards qu’avec les onduleurs, mais on peut remplacer des groupes froid traditionnels qui ont 15 ou 20 ans par du free cooling, avec des encombrements similaires en gardant les mêmes débits d’eau. Mais il faut avoir une approche plus « empreinte carbone » en général, en remplaçant la production de froid avec des gaz HFO, des fluides de 4e génération comme le R-1234ze à très faible PRC (potentiel de réchauffement climatique). L’utilisation de ce gaz, conforme à la réglementation 2030, permet une meilleure récupération de chaleur fatale avec des températures d’eau chaude de 55°. La rénovation peut souvent être plus complexe pour des datacenters d’entreprise, pour les lesquels il y a moins de redondances que pour celui d’un hébergeur Tier III ou Tier IV. Dans d’autres cas, comme IN2P3/CNRS à Lyon qui avait une salle vieillissante avec des solutions très disparates, il a été décidé de faire une salle neuve en free cooling, refroidissement In-Row sans faux plancher ».

Relever et gérer la température des salles IT

Depuis quelques années, et sous l’impulsion de l’organisation internationale technique dans le domaine des génies thermiques et climatiques, ASHRAE, les températures de datacenters peuvent être relevées sans compromettre la fiabilité et la continuité de service des équipements. Cette augmentation de consigne de température dans les salles va permettre d’augmenter durant l’année l’utilisation du free cooling ou du free chilling. Une opération qui nécessite de bien analyser les spécificités des matériels de refroidissement et des équipements IT des salles, de mesurer les températures en entrée de baie.

Damien Giroud le confirme : « Nous poussons très fort pour remonter les températures d’air et de la boucle d’eau en passant de températures de 12°-18° à 20°-30°. Ce qui permet d’avoir plus de puissance froid avec des machines plus petites. L’eau circule moins rapidement dans l’échangeur, les pompes sont plus petites, avec des variateurs de vitesse. C’est aussi intéressant pour la partie coûts d’installation. Cela permet, en rénovation, de passer plus de puissance dans les tuyaux existants. Pour les petites salles du Edge Computing, il peut être intéressant de remplacer la climatisation par une ventilation ou passer à une climatisation In-Row à détente directe avec boucle d’eau ; ce qui peut permettre de réaliser un gain de 35 % sur le refroidissement ».

L’intelligence artificielle (IA), un outil de plus en plus utilisé dans les datacenters

Comme le note David Hall, directeur principal de l’Innovation technologique d’Equinix, « optimiser un datacenter n’est pas facile. Les charges informatiques et les conditions du milieu extérieur varient considérablement, parfois de façon imprévisible ; or, en tant qu’utilisateur, on consacre évidemment beaucoup d’efforts à la modélisation, l’optimisation et l’amélioration des conceptions. L’approche par l’IA prend les données et forme un réseau de façon à ce qu’il puisse modéliser le PUE de l’installation. Les variables entrantes du modèle sont les nombreux points de données qui sont récoltés via l’infrastructure. Ce qui sert à déterminer si le réseau modélise avec justesse le rendement de l’installation dans le monde réel, c’est l’écart entre le PUE prédit et le PUE mesuré. Une fois pourvu d’un modèle capable de prédire au plus juste le PUE, on peut manipuler les variables entrantes pour simuler des scénarios hypothétiques. L’IA peut aussi contribuer à améliorer la surveillance de l’équipement et est vouée à se généraliser, à adresser de plus en plus de problèmes catégorisés » insolubles » ».

Comme le note Hatem Bouzidi, Segment Sales Manager-DataCenters d’ABB France, « initialement, les anciens datacenters étaient équipés de systèmes de conduite en îlot appelés DCIM. Cela ne permettait de prendre certaines décisions qu’en fonction d’un nombre limité d’informations et dans un seul type d’équipement à la fois.

Aujourd’hui, tous les équipements sont connectés et fournissent nombre de données, plus ou moins importantes mais qui peuvent être interactives entre elles. Pour cela, il faut qu’elles convergent vers le centre de pilotage du datacenter et que les ingénieurs puissent, en fonction de la charge IT de chacun des serveurs, de leur emplacement dans la baie, de l’implantation de ces baies dans la salle, des conditions de climatisation de ces baies, des répartitions entre les différents couloirs, de la présence ou pas de techniciens, des conditions climatiques extérieures, de la disponibilité et des consommations électriques de chacun des équipements… avoir un système qui leur permet de concaténer toutes ces informations afin de prendre les meilleures décisions en ayant un historique de tous les événements passés pour leur permettre de simuler, grâce aux jumeaux numériques et à l’intelligence artificielle, les résultats en termes de gestion économique pour les exploitants, mais aussi et surtout pour les clients du datacenter ».

Les suites logicielles proposées par les constructeurs évoluent pour intégrer cette composante IA dans les outils de gestion DCIM des centres.

« Nous proposons une nouvelle brique DCIM AI de notre suite EcoStruxure IT Advisor pour introduire un contrôle intelligent des VM et réduire les consommations d’énergie sans affecter la disponibilité, explique Damien Giroud. DCIM AI se connecte à l’environnement des serveurs virtualisés existant et utilise l’IA et le Machine Learning pour définir la configuration machine virtuelle optimale. DCIM AI migre les machines virtuelles, réduisant le nombre de serveurs physiques nécessaire et met en veille les serveurs inutiles afin de diminuer la consommation énergétique globale des serveurs. On attaque le 1 du PUE, tout en protégeant le SLA avec un modèle bien maîtrisé. »

Améliorer la surveillance du centre de données est aussi important et Schneider Electric a signé un accord avec Lenovo pour intégrer EcoStruxure Expert IT au XClarity Orchestrator de Lenovo. Cela permettra de surveiller et gérer les serveurs, le stockage, mais également les onduleurs via une console de gestion centralisée. Cela permettra aussi au client Lenovo de surveiller des paramètres tels que la température ou la consommation d’énergie. À terme, ce système pourrait utiliser les capacités d’automatisation pour inclure l’IA afin d’identifier et corriger automatiquement les défaillances d’infrastructures critiques avant qu’elles ne se produisent.

AVIS D’EXPERT

Didier Personnic, président de Kapsdata

« L’intelligence artificielle pour booster l’écoefficacité énergétique des datacenters »

Que ce soit pour l’amélioration de l’efficience énergétique, l’optimisation de la charge des serveurs, la sécurité ou la maintenance, de nombreuses publications montrent qu’il ne s’agit pas de science-fiction : l’intelligence artificielle (IA) propose des technologies numériques matures.

À titre d’illustration, le cas d’usage présenté ici concerne les difficultés d’optimisation d’un datacenter mis en exploitation en 2016 et conçu pour une puissance hébergée de 1 MW en 2N+1. Aujourd’hui, les principaux enjeux concernent l’évolution des besoins des utilisateurs qui souhaitent mettre en œuvre des solutions hyper-convergées pour mieux optimiser le plan de consolidation informatique de l’entreprise et satisfaire aux exigences de baisse des coûts informatiques (OPEX et CAPEX). Les conséquences sur l’infrastructure sont nombreuses : densité de charge IT par baie, qui passe de 6 kW maximum à plus de 20 kW, répartition des charges plus « chaotique » et plus impactante pour la distribution de froid, exploitation en mode miroir actif//actif de l’IT qui permet d’alléger les exigences de redondance de l’infrastructure de froid…

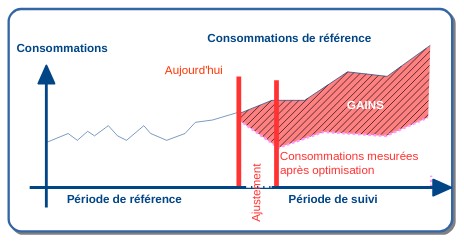

Pour instruire et chiffrer le plan de rénovation, il est nécessaire de disposer d’une représentation qualitative et quantitative du fonctionnement des sous-systèmes de l’infrastructure telle quelle (AS-IS) : c’est un des points durs pour lesquels une approche IA permet rapidement d’élaborer, sur une période de référence courte, la classification des états et des modes opératoires de l’infrastructure. Il s’agit d’extraire des mesures hydrauliques et électriques pour produire une caractérisation numérique du système. Cette représentation numérique du fonctionnement (modèle) permet d’explorer (prédictif) de nouvelles situations d’exploitation du datacenter en agissant sur les facteurs d’influence et en les faisant varier (condition météorologique, localisation et charge IT, comportement des automatismes de pilotage des groupes froid, pompes, vannes, tour de refroidissement…). Pendant la période d’ajustement, l’exploitation du modèle permet d’ajuster les exigences du plan de rénovation en y intégrant les tolérances de l’existant et les évolutions nécessaires : tant concernant l’IT que l’infrastructure. Le même modèle sera utilisé pour valider et réceptionner chaque étape de rénovation et fournira un complément indispensable au pilotage pendant toute la période d’exploitation. Le datacenter aborde ainsi une nouvelle vie : plus efficace, plus facile à piloter et plus flexible, plus frugal.

Moderniser les équipements électriques et de sécurité des datacenters

Les équipements électriques et de sécurité participent à l’efficacité énergétique du datacenter, mais aussi à sa continuité de service et à sa résilience. C’est particulièrement vrai pour les alimentations sécurisées (UPS et batteries) ou les groupes électrogènes, mais tous les équipements électriques de l’arrivée HT ou MT à l’alimentation des baies et équipements sont aussi vitaux et doivent faire l’objet de mises à niveau régulières.

Pour Hatem Bouzidi, « les composants électriques évoluent chaque année et de plus en plus, il faut rendre les équipements plus performants et up to date. Ainsi, les TGBT et TGHQ sont souvent équipés de disjoncteurs ouverts dont les caractéristiques mécaniques et électriques sont figées. Mais leurs systèmes de protection (relais) sont assez vite obsolescents. Pour limiter l’OPEX, il est donc important de pouvoir moderniser les protections des TGBT/TGHQ standards en leur apportant les toutes dernières innovations en matière de protection et de supervision, et ce, quelle que soit la marque de l’appareillage. En améliorant l’efficacité des installations électriques, avec une solution économique telle que l’Ekyp UP d’ABB, il est possible d’obtenir jusqu’à 30 % d’économie sur les coûts d’exploitation grâce au système de gestion d’énergie intégré permettant un pilotage précis de l’installation ».

Le remplacement des câbles d’alimentation des baies par des canalisations électriques préfabriquées (ou gaines à barres) en partie haute fait partie des aménagements pour mieux suivre l’évolution des installations d’une salle.

Stéphane Levillain, Sales Manager South Europe & North and West Africa de Starline (Groupe Legrand) donne l’exemple de la rénovation d’un datacenter parisien : « Un client a souhaité rénover un ancien datacenter afin d’accueillir un GAFAM pour une première tranche de puissance 6 MW IT, 2500 m2 de salle. Ce client exploite la quasi-totalité de ses datacenters avec une solution de Busways (gaine à barres) de distribution au-dessus des racks afin de standardiser ses datacenters et faciliter ses opérations. Cette gaine de distribution apporte nombre de bénéfices au client. »

La fiabilité : le Busway et les coffrets départ (tap offs) sont fabriqués en usine et testés à 100 %, ce qui garantit une installation et des essais rapides une fois sur le site. La présence d’un joint à compression sans écrous ni vis, et donc sans maintenance, ainsi que des soudures ultrasoniques, sans pièces mobiles, contribuent à cette fiabilité maximale.

L’agilité : le Busway est dit « ouvert », car il permet d’installer le coffret départ (tap off) sur toute la longueur de la gaine au-dessus de la rangée, sous tension, sans risques pour l’opérateur. Cette procédure est certifiée par le VDE, bureau de contrôle. L’opérateur peut ainsi installer lui-même le tap off dans la gaine lorsqu’il reçoit son nouveau rack IT, sans perdre de temps pour installer un nouveau câble, départ disjoncteur dans l’armoire PDU qui, d’ailleurs, a disparu dans ce type de design.

Un TCO économique : le Busway possède un coût d’installation faible et ne nécessite pas de maintenance. Les tap offs sont compatibles sur toutes les salles clients et peuvent être interchangés et réutilisés sur une rangée ou une salle différente. En ce sens, c’est plus un investissement pérenne qu’un coût.

Et les collectivités publiques, dans tout ça ?

Pour aider les collectivités, établissements de santé, ministères et administrations à améliorer, refondre, sécuriser leurs centres de données petits ou grands, l’UGAP (Union des Groupements d’Achats Publics) a confié un marché « Prestations relatives au centre de données » au groupement associant APL (bureau de conseil et expert en datacenters) et Atos (leader international de la transformation digitale). De l’audit, des études jusqu’à l’accompagnement et le suivi du bon déroulement du projet, les experts du groupement accompagnent la mise en œuvre de solutions d’optimisation à court, moyen et long terme des infrastructures.

Toutes ces opérations qui visent à rendre ces datacenters anciens plus durables et plus résilients, tout en les adaptant à la transformation numérique que nous vivons, vont certainement mobiliser tous les professionnels pour les années qui viennent.

Jean-Paul Beaudet